Adam优化器_2发布日期:2024-08-12 02:38:29 浏览次数:

看VIT的时候发现有点忘了,补一补。

Adam优化器是一种自适应学习率的优化算法,结合了动量梯度下降和RMSprop算法的思想。它通过自适应的去调整每个参数的学习率,从而在训练过程中加速收敛。

数学公式

假设在第t个时间步,目标函数为f(θ),θ表示模型的参数。

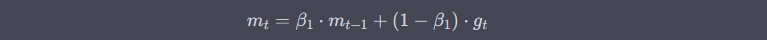

1.动量更新(Momentum Update):

参数介绍:

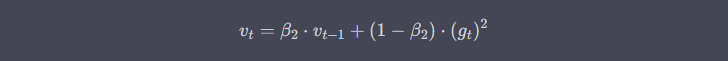

2.平方梯度更新:

参数介绍:

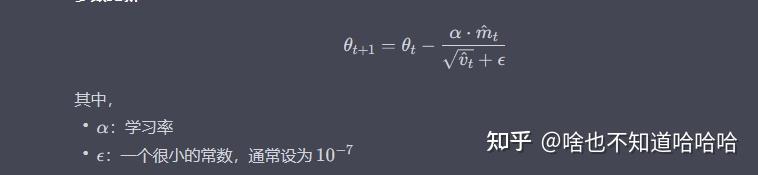

3.参数更新

上面都是GPT说的,我们看看知乎大神是如何理解这个东西的。

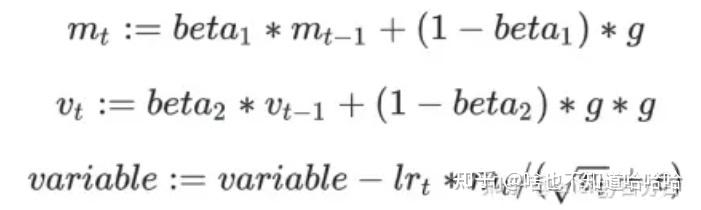

公式一:计算历史梯度的一阶指数平滑值,用于得到带有动量的梯度值

公式二:计算历史梯度平方的一阶指数平滑值,用于得到每个权重参数的学习率权重参数

公式三:计算变量更新值,正比于公式一,反比于公式二。